数据持久化的时间需要设置业务足够接受的程度,我自己业务上使用就是能保证我的数据 根据 Kafka官方文档说明,Producer发送消息持久化到 Kafka得到 ack的回馈这段过程中

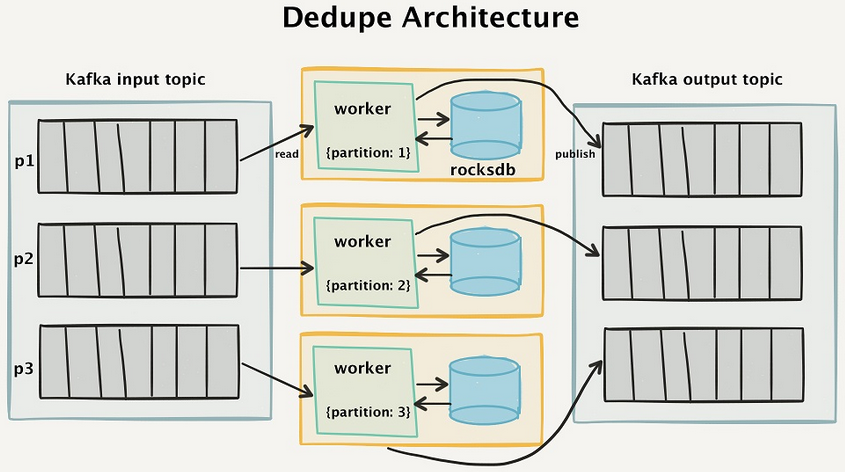

kafka offset 如何保证三种语义传递

1129x761 - 296KB - PNG

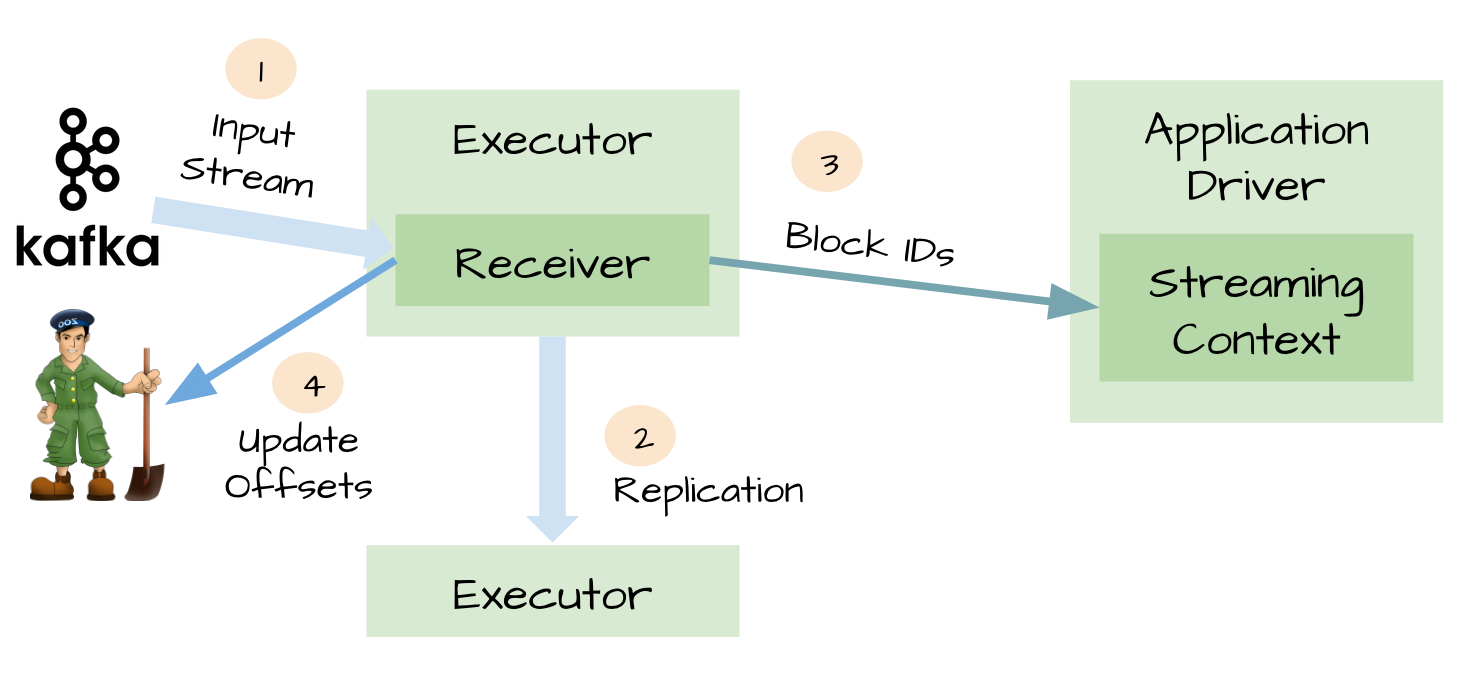

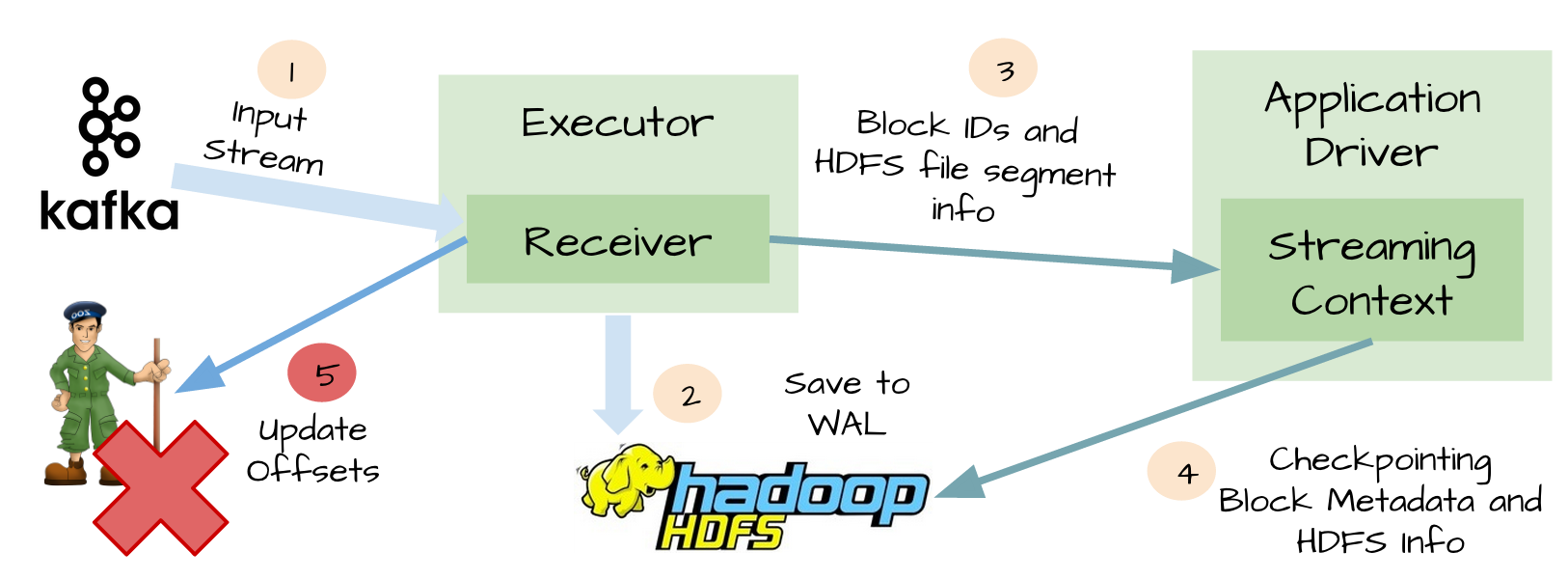

Spark Streaming使用Kafka保证数据零丢失

640x283 - 23KB - JPEG

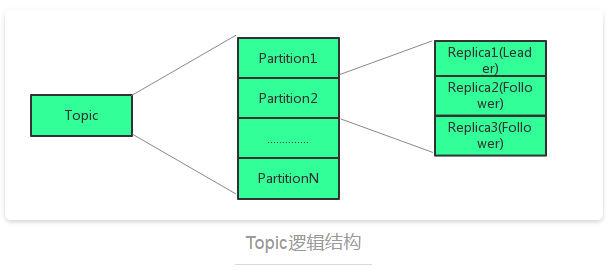

kafka精确一次投递和事务消息学习整理

845x472 - 312KB - PNG

Kafka 如何做到 1 秒发布百万条消息

600x269 - 25KB - PNG

SparkStreaming和Kafka整合是如何保证数据零

833x1179 - 224KB - PNG

SparkStreaming和Kafka整合是如何保证数据零

141x200 - 21KB - PNG

Spark Streaming使用Kafka保证数据零丢失 - T

1468x676 - 133KB - PNG

Spark Streaming使用Kafka保证数据零丢失 - T

1626x600 - 221KB - PNG

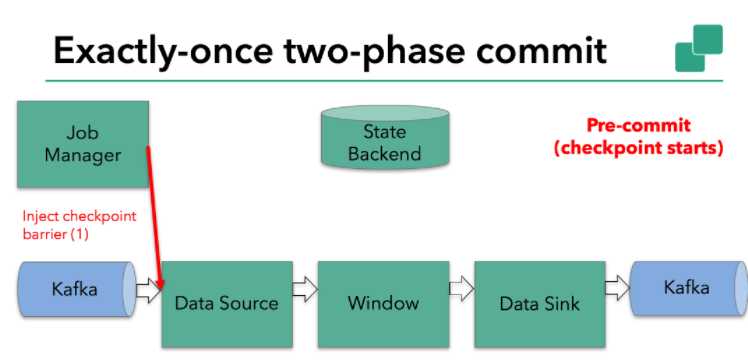

【译】Flink + Kafka 0.11端到端精确一次处理语

748x360 - 68KB - PNG

Kafka 运维纪实 -- 一次磁盘故障后消费者无法消

960x568 - 42KB - JPEG

Spark Streaming使用Kafka保证数据零丢失 - O

1676x682 - 174KB - PNG

基于Web的Kafka管理器工具之Kafka-manage

988x677 - 47KB - PNG

基于Web的Kafka管理器工具之Kafka-manage

1286x605 - 56KB - PNG

Kafka 运维纪实 -- 一次磁盘故障后消费者无法消

1080x410 - 28KB - PNG

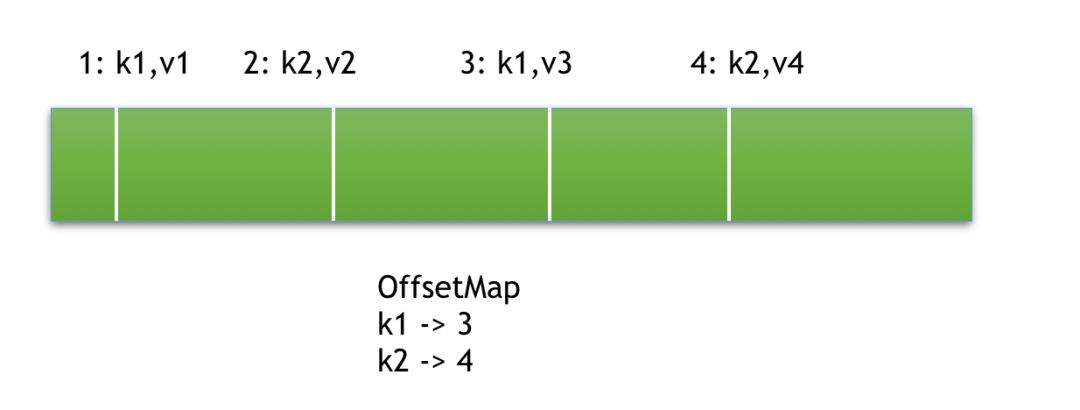

kafka精确一次投递和事务消息学习整理

550x417 - 44KB - PNG