photo source @ un splash

< p >文章|大脑极体

自然语言处理(NLP)技术正在改变我们生活的方方面面

客厅里的智能扬声器在与你的日常对话中进步很快,甚至开始与你“插科打诨”,以适应你的爱好。

电子商务客服总能在第一时间回复,并可能处理你的问题。你也没有意识到助教可能只是一个智能的客户服务。图灵测试的真实版本每天都在发生。

你可能已经习惯了一键翻译网页或几个搜索引擎,这通常是指外语材料。翻译的质量如此之好,以至于你觉得学习一门外语是浪费时间。

闲散无聊当你浏览信息流或视频短片时,你总是会在之后找到越来越多的时间来沉浸其中。事实上,它背后是自然语言算法平台根据你的浏览习惯和注意力持续时间提出的优化建议。

可追溯到它的起源。我们希望简要回顾近年来自然语言处理程序的过渡和升级,并沿着这一技术洪流追踪其源头。回到拥有丰富水源和众多水系的技术源头,了解自然语言处理的演变

NLP争夺霸权:OpenAI和GPT-2“顽固”罢工关心NLP的人必须知道2018年是NLP发展的新的一年

2年6月,018,OpenAI发表了一篇题为“通过通用预训练提高语言理解”的论文,并提出了基于“预训练语言模型”的GPT。它首先使用变压器网络而不是LSTM作为语言模型,并在12个自然语言处理任务中的9个中获得了SOTA性能然而,由于各种原因,GPT没有得到更多的关注。

GPT的基本处理方法是在大规模语料库上进行无监督预训练,并在小得多的有监督数据集上对特定任务进行微调。它不依赖于单个任务的模型设计技术,并且可以同时在多个任务中获得良好的性能。

直到10月,谷歌的《变形金刚双向编码器演示》才问世,一经发布,就受到了社会各界的广泛关注。伯特模型赢得了SOTA在11个自然语言处理任务中的表现,这使得谷歌技术人员宣称“伯特开启了自然语言处理的新时代”伯特实际上使用与GPT相同的两阶段模型。首先,它是无监督的语言模型预训练。第二种是使用微调模式来解决下游任务不同之处在于,BERT在训练前阶段使用了类似于ELMO的双向语言模型,并且在训练前使用了更大的数据规模

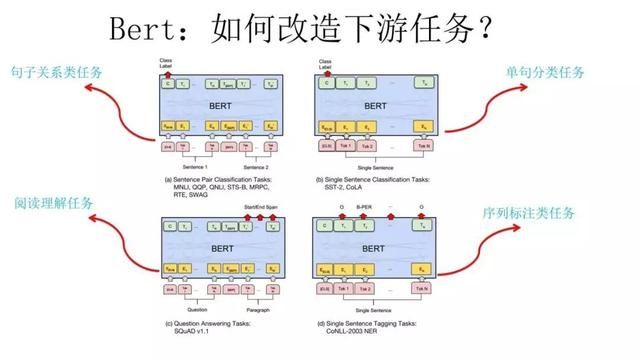

BERT正在改革自然语言处理下游任务(包括序列标记,如汉语分词、词性标记、命名实体识别、语义角色标记等)。;第二类是分类任务,如文本分类、情感计算等。句子关系判断,如蕴涵、问答、语义改写、自然语言推理等。生成性任务,如机器翻译、文本摘要、写诗和句子、看图和说话等。)以上,它强大的通用性和出色的任务性能已经成为它引爆NLP的信心。

之后仅四个月,OpenAI发布了GPT-2该大规模无监督自然语言处理模型可以生成连贯的文本段落,刷新7个大数据集的SOTA性能,并完成许多不同的语言建模任务,如阅读理解、问答和机器翻译,而无需预先培训

首先,CPT-2和BERT,像GPT一样,继续把变形金刚的自我注意作为底层结构

OpenAI研究人员坚持无监督数据训练,可能是因为有监督学习会导致语言模型只在特定任务上表现良好,而在泛化能力上表现不佳。然而,仅仅通过增加训练样本很难有效地扩展任务。因此,他们选择在更一般的数据集的基础上使用自我注意模块迁移学习来建立一个能够在零触发条件下执行许多不同的自然语言处理任务的模型

与BERT的不同之处在于CPT-2模型结构仍然延续了GPT1.0的“单向语言模型”GPT-2似乎只有一个目标:根据课文中所有先前的单词预测下一个单词。这种固执的坚持显示了OpenAI的解决方案。

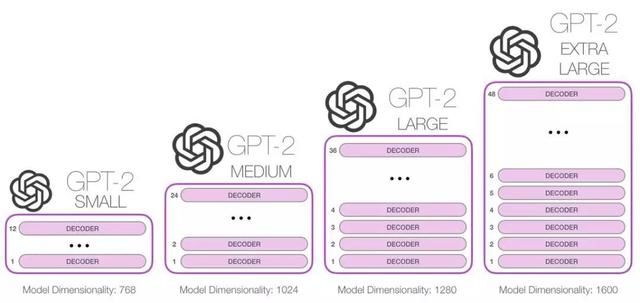

它选择将变形器模型参数扩展到48层,包括15亿个变形器模型参数,找到800万个WebText数据集作为无监督训练数据简而言之,GPT-2是GPT模型的直接延伸,训练数据量是10倍,参数量是10倍这使得GPT 2号能够采用更直接的“暴力”方法,仅仅依靠增加模型参数的容量和增加训练数据的数量来超过BERT

GPT-2作为一个文本生成器,只要你在开头输入几个字,程序就会根据自己的判断决定下一步怎么写。简而言之,GPT-2,作为一个通用的语言模型,可以用来创建人工智能写作助手,更强大的对话机器人,无监督的语言翻译,以及更好的语音识别系统。

OpenAI设想人们可能出于恶意使用GPT-2来生成误导性的新闻,在网上假冒他人进行欺诈,在社交媒体上自动生成恶意或伪造的内容,自动生成垃圾邮件或钓鱼邮件等。因此,在发布GPT2时,OpenAI宣称“这个强大的模型有被恶意滥用的风险”,并选择不为训练模型做一个完整的开源。这一举动引起了机器学习和自然语言处理领域研究人员的激烈讨论。无论

是被外界嘲笑为对自己产品的“过度自信”,还是被OpenAI出于公关目的的“刻意炒作”,GPT-2的“刻意制造虚假新闻”的实力确实打动了业内所有人。一边吃瓜,一边迫不及待地探索GPT 2号强大的发电能力。

经过将近一年的时间,GPT-2已经经历了一次令人眼花缭乱的更新和演变,伴随着谨慎的开源和开发人员的“早期采用者”

GPT-2阶段开源:开发商狂欢随着争议和开发商呼声的上升,出于谨慎考虑,OpenAI仍然选择分阶段开源。8月份之后,它分阶段发布了“小”1.24亿个参数模型(磁盘上500兆)、“中”3.55亿个参数模型(磁盘上1.5兆)和7.74亿个参数模型(磁盘上3兆)。直到11月6日,它才正式发布了GPT-2最大版本的完整代码,最后部分包含15亿个参数。在

的完整版本发布之前,OpenAI没有发现任何明确的代码、文档或其他滥用证据,也就是说,一直被担心的“GPT-2滥用”的结果没有出现。然而,OpenAI仍然相信完整版本的发布也会给恶意用户提供机会来进一步提高他们的检测规避能力。

因此,随着GPT-2的不同版本的相继发布,OpenAI本身已经与复制GPT-2模型的几个团队进行了沟通,以验证GPT-2的使用效果。同时,它还避免了误用语言模型的风险,并完善了检测文本生成的检测器。与此同时,OpenAI还与一些研究机构合作,如研究人类对语言模型生成的数字信息的敏感性,研究恶意使用GPT-2的可能性,以及研究GPT-2生成的文本的统计可检测性。

不管OpenAI有多谨慎,随着不同容量参数模型的发布,外部开发人员迫不及待地向各个方向探索。

2年4月,019年,Buzzfeed数据科学家Max Woolf使用Python封装了“较小”版本的OpenAI GPT-2文本生成模型,该模型具有1.17亿个超级参数来微调和生成脚本,并开发了“GPT-2的缩写版本”,以更好地帮助人们生成可以给出许多意外内容的文本。

在逐渐开放OpenAI的过程中,布朗大学的两名研究生率先复制了一个带有15亿个参数的GPT-2,并将其命名为OpenGPT-2。在这个过程中,他们用自己的代码从头开始训练GPT-2模型,只花了大约5万美元。所使用的数据集也尽可能参考OpenAI文件中公开的方法。经过测试,许多热情的网友表示,OpenGPT-2的输出文本效果比OpenAI的GPT-2774万参数版本要好。当然,有些人认为没有比GPT-2模型生成的文本更好的效果了。

与此同时,在中国,南京的一个名为“泽耀都”的开发者在GitHub上开发了GPT 2中文版,可以用来写诗、新闻、小说和剧本,或者训练通用语言模型。这种GPT-2模型可以实现反向效应,它使用了15亿个参数目前,他已经开发了预培训结果和Colab演示的来源。只需三次点击,人们就可以生成定制的中国故事。

GPT-2型号有更多尝试新加坡高中生里沙布·阿南德(Rishabh Anand)开发了一个轻量级的GPT-2“客户端”——GPT 2客户端,它是最初的GPT-2仓库的包装器,只能生成5行代码的文本。

中国的几位研究人员正在使用GPT模型来生成高质量的中国古典诗歌。例如,文章提到了一个“七法,一路平安”:“一只大雁在秋天飞过天空,突然梦见青城的老朋友来游泳通往绿色森林的路没有通向一匹马,有一只手里拿着一棵黄色树的返航船。在我的一生中,我将成为商山的老人。我什么时候会呆在国务卿或中国政府的办公室?安德鲁相从昨天的话域,一瓶与醉山”一个普通的告别充满了沧桑和悲伤。不难怀疑:这种语言模式真的有感情吗?

GPT-2型号也可用于音乐创作OpenAI引入了一种深层神经网络来生成音乐作品——MuseNet,这是一种与GPT 2语言模型稀疏转换器相同的通用无监督技术,允许Musenet根据给定的音符集合来预测下一个音符该模型可以用10种不同的乐器制作4分钟的音乐作品,并且可以从巴赫、莫扎特、披头士和其他作曲家那里学习不同的音乐风格。它也可以令人信服地结合不同的音乐风格,创造一个全新的音乐作品。

是一款人工智能角色冒险游戏——“人工智能地牢”,由开发者通过GPT 2制作,最吸引作者。通过多轮文本对话,人工智能可以帮助你开始一个意想不到的旅程“骑士屠龙”或“城市侦探”在未来的游戏行业,人工智能创造的故事脚本可能会更富想象力?自

GPT-2发布以来的一年中,上述开源应用程序足以称之为令人眼花缭乱。在喧嚣和繁荣的背后,除了对开源的风险保持谨慎之外,OpenAI还面临什么其他的困难?

NLP本地高级锦标赛:OpenAI与微软结婚后的GPT-2商业化事实上,我们可以从BERT和GPT-2的发展趋势中看到,人类可以通过使用更大容量的模型和无监督的无限制训练来创造更多更好的符合人类语言知识的内容。然而,这也意味着依赖超昂贵的GPU计算时间、超大型GPU机器学习集群和超长的模型训练过程。这意味着,这种“老化”模式最终将导致全国民主联盟的参与者与大公司聚集在一起,成为少数土豪的竞技场。

可以预测,如果OpenAI今年再次发布GPT-3.0,它仍然会选择高概率的单向语言模型,但它会采用更大规模的训练数据和扩展模型来匹配BERT的刚性。NLP应用程序的结果将再次刷新。

,但从另一个方面来看,这种“烧钱”的语言培训模式的研发没有明确的商业应用前景OpenAI也不得不面对商业化的艰难选择“追随技术情感的初衷”或“鞠躬五米”

的答案应该已经很清楚了就在2019年7月,OpenAI接受了微软10亿美元的投资据官方消息,OpenAI将与微软合作,为微软的Azure云平台共同开发新的人工智能技术,并将与微软达成独家协议,进一步扩大大规模人工智能能力,“兑现通用人工智能(AGI)的承诺”

的本质正是OpenAI在人工智能研究及其商业化中“烧钱”的尴尬,这使得它更有必要获得微软的这种“赞助”。以参数为15亿的GPT-2模型为例。它使用256个TPU v3训练件,每小时花费2048美元。可以预测,如果我们仍希望期待GPT-3.0的发布,成本将主要花费在云计算资源上。

微软成为OpenAI的独家云计算供应商OpenAI的人工智能技术也将通过Azure云出口。未来,OpenAI将把一些技术授权给微软,然后微软将这些技术商业化,并出售给合作伙伴。

的支持,一笔巨款,给了OpenAI更多的信心。如上所述,GPT 2号将在8月份以后继续逐步发布不同数量级的参数模型,并将在11月份开放所有来源。很明显,在未来商业化的方向上,GPT-2可以更多地依靠微软Azure的支持。例如,将来可以更好地与Office365合作,参与Office辅助的自动化文本写作,参与语法错误修复,还可以建立一个更自然、更真实的问答系统。

曾经年轻,喜欢追逐梦想,想飞向前方。AGI的理想也需要在商业实践中得到体现。可以预见,在2020年,面对微软和OpenAI的结合,谷歌将会给自然语言处理的商业化带来更多的浪潮。