神经架构搜索的发布一直被认为是高计算能力的代表。虽然可区分架构搜索的概念非常吸引人,但是它目前的效率和效果仍然不令人满意。在最新的AAAI 2020中,第四种范式提出了一种基于近似迭代的网络连接方法,这种方法的速度比飞镖快10倍以上

神经架构搜索已经引起了很多关注,因为它可以识别比手动构建的架构更好的架构。近年来,差分搜索方法因能在几天内获得高性能的网络连接存储而成为研究热点。然而,由于超级网络的建设,它仍然面临着计算量大、性能低的问题。

本文提出了一种基于近端迭代的高效网络连接方法与以前的工作不同,NASP将搜索过程重新定义为带有离散约束和模型复杂性正则化的优化问题由于新目标难以求解,我们进一步提出了一种高效的算法,该算法通过近端启发式方法进行优化。

这样,NASP不仅比现有的可微搜索方法更快,而且还能找到更好的架构并平衡模型的复杂性最后,在不同任务上的大量实验表明,NASP在测试精度和计算效率方面取得了较好的性能。虽然找到了一个更好的模型结构,但速度比现有技术如飞镖快10倍以上。此外,NASP消除了操作之间的相关性

代码:https://github.com/xujinfan/NASP-codes

此外,在WWW 2020论文“协同过滤的高效中性交互函数搜索”中,我们将NASP算法应用于推荐系统领域:

PPT:https://www.tuijianxitong.cn/cn/school/openclass/27

代码:https://github.com/quanmingyao/SIF

's快速移动神经架构搜索

深度网络已应用于许多应用,其中合适的架构是确保良好性能的关键近年来,网络连接存储成为人们关注和研究的焦点,因为它可以找到参数更少、性能更好的网络。这种方法可以代替人类专家设计建筑。

NASNet是这一领域的先驱。它将卷积神经网络的设计视为一个多步决策问题,并用强化学习来解决。

然而,由于搜索空间是离散的和巨大的,NASNet需要数百个图形处理器花费一个月的时间来获得一个令人满意的网络结构。后来,通过观察网络从小到大的良好传输性,NASNetA)提出将网络分成块,并在块或单元内搜索然后,识别出的单元被用作组装大型网络的构件这种两阶段搜索策略极大地减小了搜索空间的大小,从而显著地加速了诸如进化算法、贪婪算法、强化学习等搜索算法。

虽然搜索空间减少了,但搜索空间仍然是离散的,通常很难有效搜索。最近的研究集中在如何将搜索空间从离散变为可微这种思想的优点是梯度信息可以在可微空间中计算,从而加快了优化算法的收敛速度。

这个想法衍生出了各种技术,如飞镖平滑Softmax的设计选择和训练一组网络;SNAS通过平滑抽样方案加强强化学习NAO使用自动编码器将搜索空间映射到一个新的可微空间

是所有这些作品中最杰出的,飞镖,因为它结合了可微性和小搜索空间的优点来实现细胞内的快速梯度下降然而,它的搜索效率和识别结构的性能仍然不尽如人意

,因为它在搜索过程中维护了一个超级网络,从计算的角度来看,所有操作都需要在梯度下降过程中向前和向后传播从性能的角度来看,操作通常是相互关联的例如,作为特殊情况,7x7卷积滤波器可以覆盖3x3滤波器。当更新网络权值时,由飞镖构建的集成可能导致发现劣质架构

此外,搜索后还需要重新定义飞镖的最终结构这将导致搜索到的架构和最终架构之间的偏差,并可能导致最终架构的性能下降。

更快和更强的邻近迭代

在本工作中,第四范式提出了基于邻近迭代算子算法的NAS方法,以提高现有可微搜索方法的效率和性能我们提出了一个新的公式和优化算法,它允许在可微空间中搜索,同时保持离散结构。这样,NASP就不再需要训练一个超级网络,从而加快了搜索速度并产生了一个更好的网络结构。

这项工作的贡献在于:

除了网络连接存储过去通常讨论的搜索空间、完整性和模型复杂性之外,这项工作确定了一个全新的重要因素,即网络连接存储对体系结构的约束;

我们将NAS描述为一个受约束的优化问题,保持空间可微,但在搜索过程中强制体系结构是离散的,即在反向梯度传播期间保持尽可能少的活动操作这有助于提高搜索效率,并在训练过程中分离不同的操作正则化器也被引入到新的目标中以控制网络结构的大小。由于这种离散约束,

很难优化,并且不能应用简单的FA省适应。因此,第四范式提出了一种从近端迭代得到的新的优化算法,并消除了飞镖要求的昂贵的二阶近似。为了保证算法的收敛性,我们进一步进行了理论分析。

最后,在设计美国有线电视新闻网和RNN架构时,使用各种基准数据集进行了实验与最先进的方法相比,提出的NASP不仅速度更快,而且能找到更好的模型结构。实验结果表明,NASP在测试精度和计算效率上都取得了较好的性能。

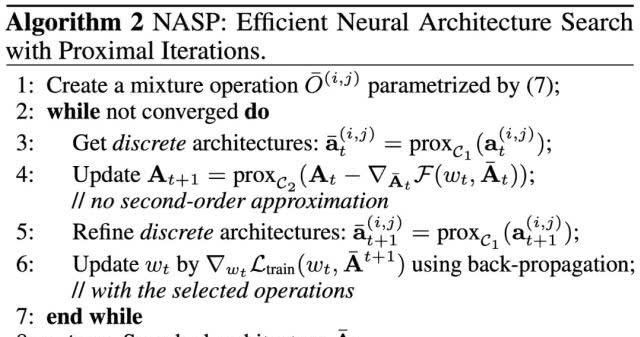

的具体算法如下:

第三步,利用相邻迭代算子生成离散结构;在第四步中,更新连续的结构参数。最后,我们更新离散网络结构下的网络权重

实验结果

美国有线电视新闻网的架构搜索

1。CIFAR-10上的搜索单元

在CIFAR-10上搜索相同的体系结构。卷积单元由N=7个节点组成,通过8次单元叠加得到网络。在搜索过程中,我们训练了一个由8个单元叠加的50个周期的小网络。这里考虑两种不同的搜索空间第一个与飞镖相同,包含7个操作第二个更大,包含12个操作

与最新的网络连接方法相比,NASP的性能与飞镖相同,在相同的空间内远远优于飞镖。在更大的空间里,NASP仍然比飞镖快得多,测试误差也比其他方法低得多。

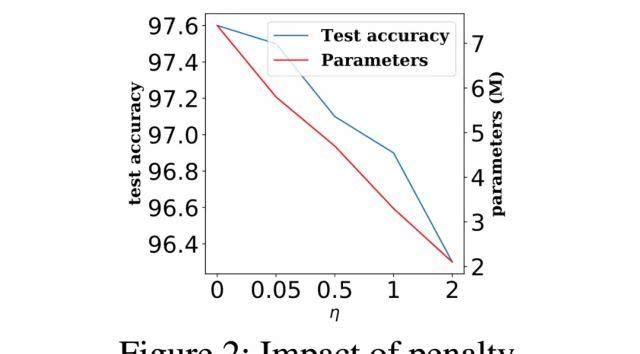

在上述实验中,研究人员调整了模型的复杂性,我们将η = 0结果表明,模型尺寸随着η的增大而减小

2。迁移到ImageNet

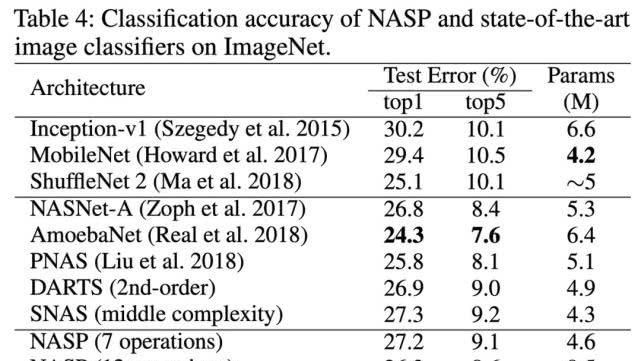

为了探索在ImageNet上的实验中发现的单元的迁移能力,我们将搜索到的单元堆叠14次值得注意的是,NASP可以使用最先进的方法来实现竞争测试错误。

RNN架构搜索

1。在PTB上,根据飞镖设置,搜索单元

由N=12个节点组成。第一个中间节点通过线性变换两个输入节点,将结果相加,然后通过tanh激活函数获得。第一个中间节点的结果应该从激活函数转换而来

在搜索过程中,我们训练了一个序列长度为35和50个阶段的小网络。为了评估在PTB上找到的单元的性能,单层递归网络使用找到的单元被训练多达8000个阶段,直到它以批量大小64收敛实验结果表明,二阶飞镖比一阶飞镖慢得多。NASP不仅比飞镖快得多,而且能达到与其他最先进方法相当的测试性能。

型号简化试验

1。通过与DARTS

实验的比较,给出了更新后网络参数和体系结构的详细比较。在相同的搜索时间内,NASP可以获得更高的精度,而NASP在相同精度下花费的时间更少。这进一步证明了NASP比飞镖更有效率

2。与同期工作相比,与同期工作的比较也被纳入

实验。ASAP和BayesNAS将NAS视为一个网络修剪问题,这将删除搜索过程中的无效操作ASNG和GDAS都随机放宽搜索空间,不同的是ASNG使用自然梯度下降进行优化,而GDAS使用Gumbel-Max技术进行梯度下降。这个实验将NASP与这些作品进行了比较。实验表明,NASP更有效,能在有线电视新闻网的任务中提供更好的表现。此外,NASP也可以适用于RNN

。刘;西蒙扬,国王;杨,杨。飞镖:可区分的架构搜索。ICLR 2019

。邻近算法。优化的基础和趋势2013

-

加入机器的核心:HR @ jiqizhixin . com

Contribute or Seek Reports:content @ jiqizhixin . com

广告与商业合作:bd@jiqizhixin.com