< p >一篇论文交付ICLR2020赢得了三个八分。完美吗?

事情没这么简单,另外两位评委给了两位1

有网友表示:这次操作是“对冲”分数

一些网民还认为,尽管论文有问题,但给出高分和低分太过极端。到底是怎么回事?

纸

论文提出了一种在语料库中同时捕获句法和全局语义的新模型

是如何做到的?

论文认为传统的RNN语言模型忽略了长距离单词依赖和句子顺序。

的新模型结合了随机梯度多模型控制和循环自编码变分贝叶斯我们不仅可以捕捉句子中的词依存关系,还可以捕捉句子和句子中话题依存关系的时间迁移。

在语料库中对的实验结果表明,该模型优于现有的RNN模型,能够学习可解释的递归多层主题,生成语法正确、语义连贯的句子和段落。

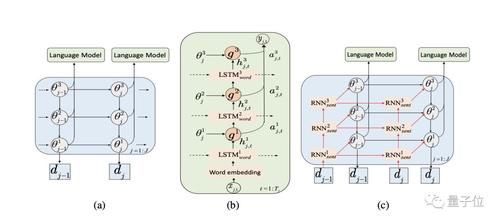

(a)(b)(c)分别是三层rGBN-RNN生成模型;语言模型组件概述;该模型的总体架构是

的第一轮审核:三个8

第一轮的三次评分都很完美。虽然分数很高,但评审都提出了一些建议。

匿名评论1

该方法结合了现有的两种方法,伽玛置信网络和叠加RNN,并利用递归伽玛置信网络的信息来改进叠加RNN

总的来说,这是一篇写得很好的论文,表达清楚,有一些新的想法。该方法具有良好的数学表达和实验评价结果看起来很有趣,尤其是捕捉长期依赖,如BLEU分数所示。一个建议是,与基线方法相比,作者没有计算和分析所提出的方法的复杂性和负荷。

匿名评论2

总的来说,我认为这是一篇写得很好的论文。我认为这是一份可以接受和发表的可靠文件。一些需要改进的地方:

奇怪的是,更不用说最近所有引人注目的基于LM的预培训工作了,我的印象是这些模型在大型多句子环境中有效工作。像BERT和GPT-2这样的模型没有考虑句子之间的关系吗?我想看到更多关于与这项工作合作的讨论。

我认为强调这个模型的贡献是不合理的,也就是说,它可以同时捕获语法和语义。我不知道其他语言模型是否不能捕捉语义(记住,语义应用于句子,不仅仅是在全局层面上)——相反,这个模型的优势似乎在于捕捉句子层面之上的语义关系。如果这是正确的,应该更准确地表达出来。

匿名评论3

该模型扩展了以前基于深层rGBN模型的面向主题语言建模方法尽管该模型的新颖性有限,但该模型的学习和推理是有价值的。此外,与SOTA方法相比,本文还展示了该方法在语言建模方面的性能改进,并说明了该方法的重要性。

另外两位评委给出了1场主席提出自己的意见后。

场主席意见

论文看起来很有趣,但是语言建模和生成方面的最新成果主要基于Transformer模型。然而,在本文中,对这些模型的任何比较和提及似乎都是明显缺失的。我想知道:作者与任何模型相比过吗?我怀疑这些模型能够在某种程度上捕捉主题,可能消除了对本文中提出的方法的需求(但是我很高兴被证明是错误的)

主席建议研究人员将他们的rGBN-RNN模型与Transformer-XL进行比较

《199》的作者说rGBN-RNN和Transformer-XL不适合直接比较。因为两者在模型大小、模型构造和可解释性上是不同的,并且Transformer-XL不尊重自然单词的边界,rGBN-RNN尊重单词-句子-文档结构从那以后,另外两个匿名评论有了很大的变化,都给了1分(拒绝)

匿名评论4

虽然的基本思想很有趣,但我最大的问题是文章开头的误导。在第一节的第二段,文章声称基于RNN的语言模型经常在句子之间做出独立的假设,因此他们开发了一种主题建模方法来建模文档级信息。这种说法有一些问题。

几乎所有评估语言建模基准的LM论文都使用LSTM/变压器通过非常简单的方法连接所有句子,并添加独特的标签来标记句子边界,从而将跨句子的文档级信息作为上下文……

匿名评论5

模型的描述令人困惑,许多陈述没有适当或充分的理由。例如:

等(1)在第2页的最后一段,他们声称在他们的模型中使用语言成分来捕获语法信息,这我不愿意接受。

(2)在第3页的第一段中,它说,“我们将d_j定义为弓形向量,只是总结了前面的句子”。没有进一步的信息。我不知道弓矢是什么样子,也不知道它是如何形成的...

更重要的是,我认为情商。(5)是错误的,这使我质疑他们的整个方法论。……

最后两位评委被主席偏袒了?还是前三个有问题?

号文中争议的关键是作者所用的新模型是否与现有方法进行了比较。

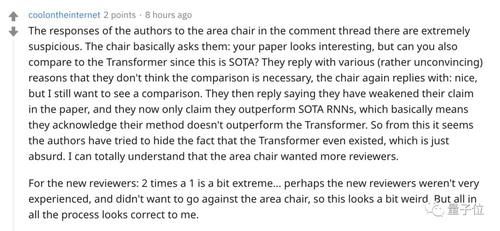

一些网民认为作者在回避这个问题

他们以各种理由回答说他们认为没有必要进行比较。主席再次回答说:很好,但我仍然希望看到一个比较。然后他们回答说他们削弱了论文中的说法,现在声称他们的表现比索塔恩更好,这基本上意味着他们承认他们的方法没有显示变压器更好。因此,从这个角度来看,作者似乎试图掩盖变压器存在的事实,这是荒谬的。

面对相反的评分,网友们有不同的意见。

有没有人认为最后两位评委一致得分最低,这真的是一场“随机”的盲目审判?

有些人还认为双方都有问题。缺乏新的方法和与变形金刚的比较肯定不能得8分,但是1分是站不住脚的。

仍然认为主席是“有节奏的”。主席认为审查可以更严格,所以他发现了两个新的审查。这导致新的审查对原来的审查产生了不信任。

也有网友说这个问题有代表性

这反映了当今机器学习中更广泛的常见问题。评论如此混乱,以至于许多提交给高层会议的意见都大相径庭。事实上,论文获得完美的评价和最低的分数是很常见的。我不确定所有的确切原因,但我认为这与该领域的研究数量和速度有关:论文被立即上传到arxiv,在下一次会议上,将会有许多研究在没有同行评议的情况下跟进这项研究。再加上该领域的大容量和年会的压力/截止日期,而不是每月或每周的科学期刊,这种情况开始发生。

这是特殊情况还是值得注意的普遍现象?

边肖记得,他周围同学的毕业论文的盲考也是通过两个层次的分化来评价的。你有过类似的经历吗?