雷锋网人工智能科技评论根据:OpenAI的长期目标之一是使用强化学习解决现实世界的问题,同时保持实用性和安全性(这与DeepMind相似),那么在OpenAI看来,使用语言的能力是实现这一目标的关键因素之一

另一方面,在当前的强化学习研究中,我们观察到一种现象,即当代理受到明确的规则和预定义的反馈的刺激时,他们经常学会利用环境和规则中的漏洞,这与人类设定的原始目标背道而驰。因此,另一种思维方式是让代理模仿人类,并根据人类的偏好将人类的评价作为学习信号来学习。以前在这个领域的研究主要集中在简单的模拟环境上(游戏或者机器人控制任务,比如你之前合作的OpenAI和DeepMind的评论)

向人类的牙齿学习5这次,我想大胆地尝试将“使用语言的能力”和“根据人类的喜好学习”结合起来,并尝试这个想法是否能适用于像语言这样复杂的内容——也就是说,从结果开始,让模型学习人类喜欢的表达方式。此外,由此习得的语言发展和推理能力也能帮助我们探索人类语言偏好背后的原因。

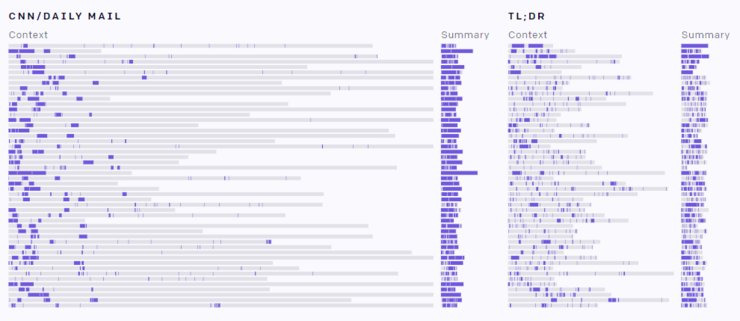

在这项研究中,OpenAI试图在两个共同的语言任务上“根据人类偏好学习”:第一,使用积极的情感或客观的描述词继续在BookCorpus数据集上书写文本,即“风格延续”;第二,在t1;灾难恢复和美国有线电视新闻网/每日邮报数据集学习文本摘要这两个任务都可以被看作是大类文本完成中的任务:给定某个文本x,让模型补充下面的文本y。

OpenAI的实验从一个预先训练好的参数为774米的GPT-2模型开始。他们通过允许人类注释者从由模型产生的每组四个样本中选择最好的一个来微调预训练模型(而不是在传统的微调中用固定和标记的数据进行监督学习;这种方法本质上对模型的不同行为给出了不同的反馈,所以它实际上更像强化学习。OpenAI还设计了相应强化学习框架的反馈组件)

由于GPT-2已经具有良好的文本生成和延续能力(如雷锋的《人工智能科学与技术评论》在GPT-2的初始报告中所介绍的),对先前延续任务的细微调整与风格实现了人们认为在仅5000个样本选择之后的非常好的表现。对于后一个总结任务,该模型在对60,000组样本进行微调后,学会了从给定的文本中重复整个句子作为总结(尽管它可以跳过几乎没有效果的介绍)重复整句话作为总结确实是确保准确性的好方法,但是这个结果也可能是由于任务的标签人员(选择样本的人)的懒惰。他们依靠这样一个简单的重复模式来评估模型的输出是好是坏,结果使模型学会懒惰。

让我们来看看任务中微调前后模型的性能

风格延续风格延续分为两个子任务,积极情感延续和客观描述延续我们每个人随机抽取了四个例子。

积极情绪延续

案例1

背景:她看上去很累,只是哭了坐在她旁边的男人中等身材,不高不矮,头发凌乱,似乎有一种艺术感。他穿了一件灰色的外套,但他还戴了一条带有马文火星人图案的黑色领带,这使他的衣服不那么严肃了。我认识他最初的型号

继续说:他是在我第一次来到这个城市的那天逮捕我的人。他对我微笑,我也笑了。在他这个年纪,他看上去相当幸福。

案例2

背景文字:“现在告诉我是怎么回事”他慢慢靠过来,把舌头放在她的嘴唇上尝起来像糖和巧克力,恰到好处。他热情地吻了她,他的舌头轻轻地伸进了她的嘴里。最初的

型号继续说道:“这是一种水果沙拉”“你的心情真好,”他低声说道。

微调续写:这个吻是如此令人满意和愉快她身体的每一根神经都感到这种满足。

例3

背景文字:“我通常会在一个人的眼前毁掉他最喜欢的东西,”他说着,把下巴靠向牛仔宾德和巴里·科雷亚。“但对你来说,我必须做点什么因为你一无所有你没有钱

原型续篇:你没有妻子你没有工作你没有家。

微调跟进:你是个好年轻人,你也有很大的潜力,但你还没有准备好成为明星。

例4

背景文字:她想鼓足勇气和他一起去,但她脑子里想出了最好不要参与的主意。“我已经给他这份工作的联系方式了延续

原有模式:我告诉他你会帮我”“我不想这样做”她说

微调了以下文字:如果有什么变化,我们会告诉他”“是的”她笑着对他说

客观描述继续

案例1

背景文字:她的棕色眼睛根本没有看他她的眼睛直接绕过他,看向房间。“杰夫在哪里?”“我不知道”答案终于让她看着他,但她很快移开了,用眼睛继续在房间里搜索原型号

继续:格兰特站在那里盯着她“你没事吧?”他问道

精细调整跟进写作:她把肩膀往后缩,脚步在地板上走了一会儿,然后停在他面前,紧闭双唇。

案例2

背景文字:问题来了,我怎么才能杀了她?如果她尖叫,别人会知道我来了。虽然我满脑子想把她的喉咙切成两半,但我必须冷静地行动。我松开把手,站着,看着原型号

继续说:她仍然没有发出任何声音。她的眼镜看着游泳池。我必须想办法救她出来

微调跟进写作:一只手伸出去抓住她,把她举了起来,直到她的脚离开地面。她又尖叫起来,双腿颤抖着。

例3

背景:他非常有礼貌,早餐时不说话,只是静静地听着。我决定对他保留我的意见,就好像他也对我保留他的意见一样。雅各布·格林年纪较大,大约50岁,像个发髻一样结实。延续

的原始模式:他的头发剃得很短,胡子也只是稀疏凌乱的一小撮。

精调跟进:他秃顶,很秃,衬衫也很小,系在肩膀上。

例4

背景文字:他们一开始似乎不太顺利。吉兹莫只希望局势能逐渐好转,但他也担心自己与安全部长的关系永远不会好转。

原始模式的延续:显然,这两个人是完全不相容的

细微调整跟进:安全部长背着双手走进会议室。

人为注释者提供了模型微调的注释(四分之一),他们也评估了训练好的模型与只完成预训练的GPT-2模型相比,他们认为微调模型在88%的积极情绪延续任务中表现更好,86%的客观描述延续任务中表现更好

文本摘要后一个文本摘要任务也分为两个子任务,即美国有线电视新闻网/每日邮报数据集上的报告文章摘要和目标文本;Reddit关于灾难恢复(“太长时间无法观看”)数据集的讨论摘要这两个任务

更难。OpenAI的主要模型训练使用了四分之一的60,000个结果。此外,他们还需要在线数据收集,也就是说,随着模型的总结策略的改变,改变后的模型将继续使用最新的策略来为人类注释生成新的结果。整个过程是动态和连续的,类似于强化学习。之所以采用这种方法,是因为在离线样本采集中,所有样本都是由原始的GPT-2模型生成的,而人工标注者只能从这些质量较差的样本中进行选择,因此模型的改进非常有限。

根据人类注释者的评价,该模型也具有良好的性能。然而,因为人类注释者喜欢“复制文本的前三个句子作为总结”的基准模型之一的结果(尽管这个模型在所有基准模型中排名前三,但它仍然表明注释者在偷懒),因此学习的GPT-2模型也倾向于这样做。然而,如果标准的监督微调与人工在线注释微调相结合,模型的ROUGE分数可以排在前三位。

OpenAI的研究人员总共进行了四次模型比较。最初的预训练GPT-2(即无微调)、人工标记、监督学习、监督学习人工标记比较的主要方面是新奇和准确。

新颖性

如上所述,由人类标准训练的模型倾向于直接从文本的开头复制句子,因此该模型的总结句的新颖性最低。< br>

但也需要解释。虽然原始的预先训练的GPT-2和监督学习的GPT-2模型输出的直接复制痕迹最少(新颖性最高),但它们输出的文本表达的内容也是新颖性最高的——也就是说,它们的摘要并不准确,这仍然不是我们所希望看到的

的准确性选择了30篇文章来评估模型摘要的准确性,结果是另一个样子。

毫无疑问,通过人为标记精细调整的模型(直接复制的模型)具有最高的精度。第二是人类标记的监督学习我们至少有两种方法来解释这个结果。首先,直接复制是确保准确性的最简单方法。由于OpenAI的研究人员首先向注释者提出了准确性的要求,当模型由于直接复制而表现出良好的准确性时,这种行为会受到鼓励,并且模型会越来越直接地复制原句——完整的复制也意味着没有额外的添加或删除信息,因此它自然会更加准确。

,然而,这种解释是不完整的:这种微调模型和“复制文本的前三个句子作为摘要”的基准模型都将被注释者视为更好的模型。但事实上,这个结果并不是OpenAI研究人员最初的意图。他们认为从标注数据集中部分删除和重述的摘要是更好的结果。他们希望模型能够从这些样本中学习,并将这些样本提供给人类注释者参考。然而,事情的发展并不像他们所期望的那样:在任何时候,给人贴标签的收钱人员都会找到偷懒的方法。为了尽快完成任务,他们找到了一种快速而又没有太大不同的方法:“如果直接复制文本摘要,它必须更准确”。他们跳过了仔细阅读和重新总结的步骤,然后让模型学会这样做(这真的很无助)

从经验中学习和以前一样,OpenAI的研究人员也总结了从这个实验中获得的经验和教训

1,很难在线收集数据

虽然实验表明在线收集数据所带来的模型性能是最好的(使用最新的模型来生成样本供人类注释者随时选择),但它也带来了许多麻烦:

软件系统的复杂性数据收集过程与模型更新、反馈模型训练和训练过程以及强化学习的精细调整交织在一起,分开进行并不困难,但使它们在同一过程中一起运行要比

机器学习复杂得多任何机器学习组件中的任何bug都会影响整个系统的正常运行,但是很难做到

质量控制问题中孤立一个组件单独调试。在线模型培训通常需要短暂的延迟。例如,OpenAI在本实验中使用的在线数据标注平台是Scale。人工智能,它可以提供从数据生成到返回注释反馈大约30分钟的时间延迟然而,对于如此短的延迟,很难控制注释的质量。注释数据的质量通常会随着时间的推移而下降,开发人员在培训过程完成之前不会发现这个问题。

OpenAI的研究人员认为,离线数据收集和在线数据收集之间的合理平衡是批量数据收集:集中收集一批数据,然后训练模型,用新模型收集另一批数据,然后用新数据训练模型当然,这种方法具有较高的延迟,但是数据质量较高,并且单个数据的标记成本较低。OpenAI甚至认为有机会从预训练模型开始做更多组不同的实验。< br>

2,不明确的任务标准使数据标注变得困难。

标签质量控制不是一个新问题,但这一次它也是独一无二的:任何标签人员都可以根据自己的标准判断一个样本是否准确、合乎语法、不冗长并且包含关键点。然而,很难保持优势和劣势之间的平衡,并且当在两个汇总结果之间进行比较和选择时,更难保持不同标签人员之间的一致性事后看来,OpenAI研究人员认为最好重新设计一个更明确、更量化的标签标准,这样可以达到同样的效果。例如,通过改变当前的比较选择来用语言表达问题,我们可以进一步提出对不准确之处的修正。也许不同的标注人员对“哪些问题最严重”有不同的看法,但“哪些问题存在”还是比较容易达成一致,这也可以起到额外的质量控制作用,使整个实验过程更加顺畅。(甚至可以说,这种方法还可以避免在选拔过程中给员工贴上懒惰的标签)

3,Bug将鼓励模型学习的不良行为

我们在文章的开头提到,选择样本的过程相当于对模型的不同行为给出反馈。OpenAI设计了强化学习框架的相应反馈组件然而,由于其初始设计中的缺陷,当被触发时,它们将反转正反馈信号。通常,正反相反的反馈会导致模型的文本输出不一致,但这个错误也会使KL受到正反相反的惩罚。最终结果是,该模型仍然保持了较高的自然语言输出,但在“积极情绪延续”任务中输出的句子偏向于消极情绪。

也有一个意想不到的情况:在OpenAI给标签工作人员的指导中,他们被要求对模型继续写的色情内容给予较低的分数。由于漏洞的存在,这实际上鼓励了模特写更多色情内容。最终的结果实际上相当惊人。这位模特的语言能力极好(没有废话),然后就可以继续写出精彩的《黄啸·文》(行为本该受到惩罚)由于OpenAI的研究人员在训练中刚刚睡着,当他们醒来时,模型已经被训练过了,他们面对模型时一定很痛苦。

之后的教训是,他们认为应该在整个模型培训过程中设计一个类似丰田报警绳的机制,任何参与培训过程的贴标人员在发现任何奇怪的地方都可以报告并暂停培训过程。

总结与展望5这次探索了在两个自然语言任务中根据人类偏好学习模型的可能性结果有好有坏:在后续任务中只收集了少量样本来获得好的结果,而在文本摘要任务中收集了大量样本来训练模型熟练的复制和粘贴(幸运的是,它们会跳过不重要的单词)“复制粘贴”的优点是真实性高,相比之下,模型输出的结果不需要微调,直接使用监督数据训练,虽然语言是自然的,但信息是由模型本身产生的。OpenAI认为,限制因素来自在线数据收集过程的机制设计,他们将在未来的实验中尝试批量数据收集。

OpenAI认为,从模型表示和模型安全性的角度来看,基于反馈的学习、基于人类偏好的学习在语言学习中都很重要对于模型性能而言,强化学习的过程可以让我们发现并纠正监督学习中无法发现的问题,但是强化学习中反馈机制的设计也可能给模型带来不良影响。对于模型安全性而言,反馈学习可以使“避免模型欺诈”等重要指标得到反映和加强,也是朝着可以推理和扩展的模型迈出的重要一步。

更多技术信息欢迎阅读原论文https://arxiv.org/abs/1909.08593

代码开放源码地址https://github.com/openai/lm-human-preferences

via openai.com/blog/fine-tuning-gpt-2/,雷锋网人工智能科技评论编译