Flume, Kafka和NiFi,大数据实时日志数据收集、

640x436 - 108KB - JPEG

Kafka学习笔记 -- 读取数据

300x346 - 70KB - PNG

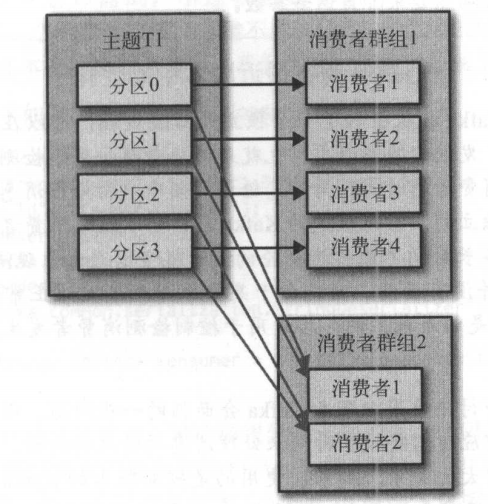

Kafka权威指南 读书笔记之(四)Kafka 消费者一

488x504 - 231KB - PNG

批处理ETL已死,Kafka才是数据处理的未来?

800x532 - 53KB - JPEG

Confluent创始人Jun Rao:如何把Kafka建成实时

640x640 - 29KB - JPEG

Kafka某topic无法消费解决方案&Kafka某Topi

614x260 - 38KB - JPEG

Apache Kafka:大数据的实时处理时代

800x450 - 35KB - JPEG

kafka 数据可靠性深度解读 - 大数据_CIO时代网

640x305 - 191KB - JPEG

Kafka某topic无法消费解决方案&Kafka某Topi

640x260 - 39KB - JPEG

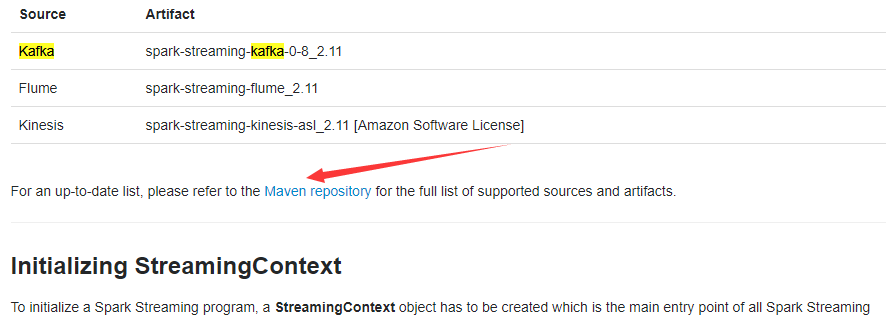

sparkStreaming获取kafka数据(java版本)

886x321 - 31KB - PNG

整合Flume和Kafka完成数据采集

650x327 - 16KB - PNG

以Kafka Connect作为实时数据集成平台的基础

678x260 - 12KB - JPEG

Flume Kafka Storm Redis构建大数据实时处理

349x494 - 23KB - JPEG

以Kafka Connect作为实时数据集成平台的基础

678x260 - 76KB - PNG

批处理ETL已死,Kafka才是数据处理的未来?

800x533 - 84KB - JPEG

获取kafka数据所以不需要有Receiver 所以也就没有获取数据,然后将数据存在内存block里面,也就没有block

最近接触了一下kafka,想要从kafka每半小时获取数据用于更新学习,找了相关的朋友推荐,是用flume来实现半

类似把sql的insert into 套在应用程序里面一样的获取数据呢?2.kafka是生产消费数据,我就纳闷一个工具是

有网友碰到过这样的如何通过kafka的javaapi的Consumer 从kafka获取数据,问题详细内容为:如何通过kafka的

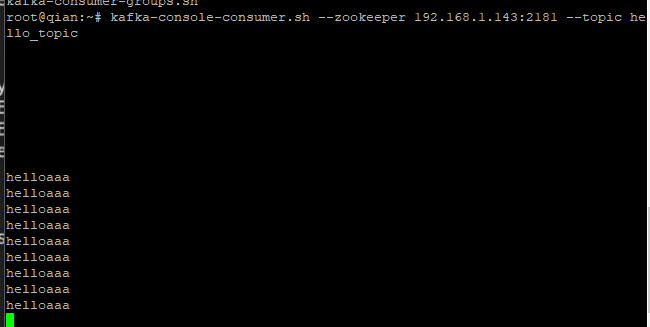

还有一种是先连接 zookeeper 然后再通过 zookeeper 获取 kafka 的 brokers 信息,offset 存放在 zookeeper

从kafka中获取数据写入到redis中,需要用到spark中的redis客户端配置,请参考前面的博客

当有多个应用程序都需要从Kafka包括群组协调、partition再均衡、发送心跳/以及获取数据,开发者只要处理从

5.High-level接口中获取不到数据的时候是会block的 简单版, 简单的坑,如果测试流程是,先produce一些数据

.map((_,1)).toMap var values=new Array[String](7)/*创建Streaming 从kafka topic中获取数据